Drei Wege zum Aufbau von KI-Gruppenchats: Warum wir den schwierigen Weg gewählt haben

Die Frage, mit der alles begann

"Warum kann nicht jeder Charakter seine eigene Nachrichtenblase haben, wie in anderen Apps?"

Diese Frage bekommen wir oft. Und ehrlich gesagt ist es eine gute Frage. Die meisten Chat-Apps zeigen Nachrichten als separate Blasen - eine pro Person. Warum also kombiniert unser Gruppenchat mehrere Charakterantworten in einer einzigen Nachricht?

Die Antwort ist weder Faulheit noch ein Versehen. Es ist eine bewusste technische Entscheidung, die aus monatelangen Experimenten mit drei grundlegend verschiedenen Ansätzen für KI-Gruppenkonversationen entstanden ist.

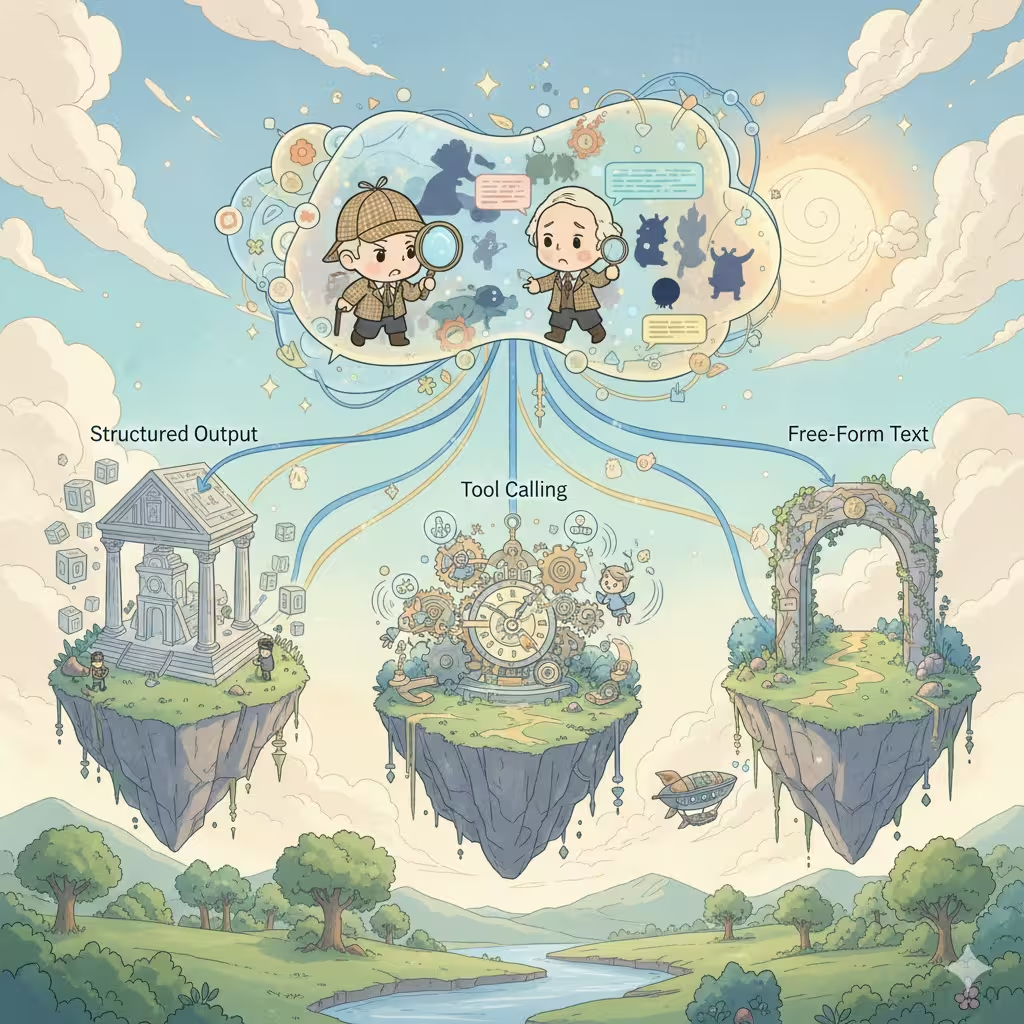

Die drei Architekturen

Beim Aufbau von KI-Konversationen mit mehreren Charakteren steht jede Plattform vor der gleichen Entscheidung. Es gibt genau drei Möglichkeiten, jede mit tiefgreifenden Auswirkungen auf Kosten, Qualität und Benutzererfahrung.

1. Strukturierte Ausgabe (JSON-Arrays)

Der häufigste Ansatz in der Branche. Man bittet die KI, ein JSON-Array zurückzugeben, in dem jedes Element die Antwort eines Charakters darstellt:

[

{

"speaker": "Sherlock",

"emotion": "fasziniert",

"content": "Faszinierend. Das Schlammmuster deutet darauf hin..."

},

{

"speaker": "Watson",

"emotion": "verwirrt",

"content": "Holmes, was meinen Sie?"

}

]Die Vorteile:

- Ein API-Aufruf, einmaliger Credit-Verbrauch

- Einfach zu parsen und als separate Nachrichtenblasen darzustellen

- Kann reichhaltige Metadaten enthalten (Emotionen, Aktionen, Szenenbeschreibungen)

- Perfekt für die Generierung von Antwortvorschlägen

Die Realität:

- Nur teure Premium-Modelle (Claude, GPT-4) unterstützen strukturierte Ausgabe zuverlässig - die meisten erschwinglichen Modelle haben Probleme mit konsistenter JSON-Formatierung

- Formatfehler brechen die gesamte Antwort ab

- JSON-Anweisungen verbrauchen Tokens und reduzieren den kreativen Spielraum

- Modelle fühlen sich "eingeschränkt" - Kreativität leidet oft

- Inhaltsbeschränkungen werden strenger: Der strukturierte Ausgabemodus löst oft aggressivere Inhaltsfilterung aus, wodurch reife oder gewagte Rollenspiel-Szenarien eher fehlschlagen

- Kontextverschmutzung: Ihr Gesprächsverlauf füllt sich mit JSON-Strukturen

- Komplexität der Fehlerbehandlung: Was passiert, wenn das Parsen mitten im Streaming fehlschlägt?

Die meisten Drittanbieter-Charakterplattformen verwenden diesen Ansatz. Er funktioniert, aber die Einschränkungen sind real.

2. Tool-Aufrufe (Agentenmodus)

Der "intelligenteste" Ansatz. Die KI entscheidet, welcher Charakter als nächstes sprechen soll, ruft ein Tool auf, um dies anzuzeigen, und generiert dann die Antwort dieses Charakters. Wiederholen, bis die Szene vollständig ist.

KI denkt: "Watson sollte auf diese Enthüllung reagieren"

→ ruft Tool auf: next_speaker("Watson")

→ generiert Watsons Antwort

→ KI denkt: "Jetzt würde Sherlock einwerfen"

→ ruft Tool auf: next_speaker("Sherlock")

→ generiert Sherlocks Antwort

...

Die Vorteile:

- Natürlichster Gesprächsfluss

- KI hat volle kreative Kontrolle über das Szenentempo

- Jede Charakterantwort erhält dedizierte Generierungsqualität

- Produziert natürlich separate Nachrichten pro Charakter

Die Realität:

- Mehrere API-Aufrufe = mehrfache Credit-Gebühren

- Latenz summiert sich: N Charaktere = N Roundtrips

- Nur High-End-Modelle (Claude, GPT-4) handhaben Tool-Aufrufe zuverlässig - günstigere Modelle scheitern oft oder halluzinieren Tool-Aufrufe

- Komplexes Zustandsmanagement über Aufrufe hinweg

- Risiko von Endlosschleifen oder unerwartetem Abbruch

- Debugging-Albträume: Probleme sind schwer zu reproduzieren

Dies ist die "Traumarchitektur", die auf dem Papier wunderschön aussieht, aber im großen Maßstab betriebliche Kopfschmerzen verursacht.

3. Freitext-Ausgabe (Unsere aktuelle Wahl)

Der einfachste Ansatz. Bitten Sie die KI, die Szene natürlich zu schreiben und selbst zu entscheiden, wie mehrere Charaktere in fließender Prosa präsentiert werden:

Sherlock beugte sich vor, die Augen scharf. "Faszinierend. Das

Schlammmuster deutet darauf hin, dass unser Verdächtiger von der

Ostseite kam."

Watson runzelte die Stirn. "Holmes, was meinen Sie? Es ist nur Schlamm."

"Nur Schlamm?" Sherlock lächelte. "Mein lieber Watson, es gibt

nichts, was 'nur' irgendetwas ist."

Die Vorteile:

- Funktioniert mit jedem KI-Modell, keine speziellen Funktionen erforderlich

- Maximale kreative Freiheit - KI schreibt natürlich

- Sauberer Kontext: Gesprächsverlauf liest sich wie ein Roman

- Ausgezeichnete Streaming-Erfahrung

- Ein Aufruf, vorhersehbare Kosten

- Am einfachsten zu implementieren und zu warten

Die Realität:

- Alle Charaktere in einem Nachrichtenblock

- Kann nicht einfach die Antwort eines einzelnen Charakters neu generieren

- UI-Flexibilität ist begrenzt

- Nutzer, die Chat-Stil-Blasen erwarten, könnten verwirrt sein

Wir haben das auf die harte Tour gelernt

Hier ist etwas, das wir bisher nicht öffentlich geteilt haben: Unsere erste Version des Gruppenchats verwendete Tool-Aufrufe.

Wir glaubten an die "Traumarchitektur". KI entscheidet, wer als nächstes spricht, jeder Charakter bekommt dedizierte Generierung, schöne separate Nachrichtenblasen. Es war elegant. Es war intelligent. Es war auch eine Katastrophe in der Produktion.

Nutzer erlebten unvorhersehbare Kosten - manchmal das 3-fache dessen, was sie für die gleiche Konversation erwartet hatten. Antwortzeiten variierten stark, je nachdem, wie viele Charaktere die KI einbezog. Günstigere Modelle halluzinierten Tool-Aufrufe oder steckten in Schleifen fest. Unsere Fehlerprotokolle füllten sich mit Randfällen, die wir nie vorhergesehen hatten.

Nach Monaten von Patches und Workarounds trafen wir die schwierige Entscheidung, von Grund auf mit Freitext-Ausgabe neu aufzubauen. Es fühlte sich wie ein Rückschritt an. Aber manchmal ist die "weniger intelligente" Lösung die klügere Wahl.

Warum wir diese Entscheidung getroffen haben

Nachdem wir alle drei Ansätze ausgiebig getestet haben - und einen in Produktion gebracht haben - haben wir uns für Freitext-Ausgabe für den Gruppenchat entschieden. Hier ist der Grund:

Stabilität vor Features - Strukturierte Ausgabe versagt unvorhersehbar. Wenn Ihr Gruppenchat mitten im Gespräch abstürzt, interessieren sich die Nutzer nicht mehr für separate Blasen - sie wollen nur, dass es funktioniert. Freitext versagt nie wegen Formatproblemen.

Qualität vor Quantität - Eingeschränkte Formate reduzieren subtil die KI-Kreativität. Als wir die Ausgaben verglichen, produzierte Freitext durchweg lebendigere, natürlicher wirkende Charakterinteraktionen. Die KI konnte sich auf das Geschichtenerzählen konzentrieren statt auf JSON-Syntax.

Kostenvorhersehbarkeit - Der Agentenmodus berechnet pro Charakter pro Antwort. Eine Szene mit fünf Charakteren könnte 5-10x mehr kosten als erwartet. Nutzer verdienen vorhersehbare Preise.

Universelle Kompatibilität - Wir unterstützen mehrere KI-Modelle. Nicht alle unterstützen strukturierte Ausgabe oder Tool-Aufrufe gleich gut. Freitext funktioniert überall und gibt Nutzern mehr Modellauswahl.

Der Kompromiss, den wir akzeptieren

Ja, wir opfern die "eine Blase pro Charakter"-Erfahrung. Aber wir gewinnen:

- Felsenfeste Zuverlässigkeit

- Bessere kreative Qualität

- Vorhersehbare Kosten

- Breitere Modellunterstützung

- Saubererer Gesprächsverlauf

Für Gruppen-Rollenspiele, wo Immersion am wichtigsten ist, glauben wir, dass dieser Kompromiss es wert ist.

Was kommt: Story-Modus

Hier ist etwas Spannendes: Wir bauen einen neuen Story-Modus, der strukturierte Ausgabe verwendet.

Warum der andere Ansatz? Der Story-Modus hat andere Prioritäten:

- Präzise Szenenkontrolle ist wichtiger als freie Kreativität

- Reichhaltige Metadaten (Kamerawinkel, Musik-Cues, Kapitelumbrüche) bringen Mehrwert

- Das Format ist vorhersehbarer (klare Kapitel-/Szenenstruktur)

- Nutzer erwarten eine "produziertere" Erfahrung

Verschiedene Anwendungsfälle verdienen verschiedene Architekturen. Wir sind nicht dogmatisch bei einem einzelnen Ansatz - wir wählen, was den Nutzern am besten dient.

Die ehrliche Wahrheit

Es gibt keine perfekte Lösung für KI-Konversationen mit mehreren Charakteren. Jeder Ansatz tauscht etwas Wertvolles gegen etwas anderes ein.

Andere Plattformen, die separate Blasen zeigen? Sie verwenden wahrscheinlich strukturierte Ausgabe und akzeptieren deren Einschränkungen. Plattformen mit "intelligenterer" Szenenkontrolle? Wahrscheinlich Tool-Aufrufe mit höheren Kosten und Latenz.

Wir haben den Weg gewählt, der priorisiert, was unsere Nutzer am meisten schätzen: Zuverlässiges, kreatives, kosteneffizientes Gruppen-Rollenspiel.

Die Erfahrung mit separaten Blasen ist nett. Aber nicht auf Kosten von allem anderen.

Was wir erforschen

Wir experimentieren mit hybriden Ansätzen:

- Nachbearbeitungs-Parsing: Verwendung leichtgewichtiger Modelle, um Freitext nach der Generierung in Charaktersegmente aufzuteilen

- Optionaler strukturierter Modus: Power-Usern ermöglichen, strukturierte Ausgabe zu wählen, wenn sie präzise Kontrolle benötigen

- Intelligente Szenenerkennung: Automatisches Identifizieren natürlicher Trennpunkte für bessere UI-Darstellung

Das Ziel ist nicht, die "richtige" Antwort zu finden. Es geht darum, die Erfahrung weiter zu verbessern und gleichzeitig zu bewahren, was funktioniert.

Haben Sie Gedanken darüber, wie Gruppenchat funktionieren sollte? Wir würden gerne von Ihnen hören.

Bereit für dynamische KI-Gespräche?

Schließen Sie sich Tausenden von Benutzern an, die bereits unendliche Persönlichkeiten und fesselnde Interaktionen auf Reverie erkunden.